- INTRO

- Lectures XVIIe-XVIIIe

- Lectures XIXe-XXe

- 1820-1840

- 1840-1860

- 1860-1880

- 1880-1900

- 1900-1910

- 1910-1920

- 1920-1930

- 1920s

- Breton

- Tanguy - Ernst

- Eluard

- Jacob - Cocteau

- Gramsci - Lukacs

- Woolf

- Valéry

- Alain

- Mansfield

- Lawrence

- Bachelard

- Zweig

- Larbaud - Morand

- Hesse

- Döblin

- Musil

- Mann

- Colette

- Mauriac

- MartinDuGard

- Spengler

- Joyce

- Pabst

- S.Lewis

- Dreiser

- Pound

- Heisenberg

- Supervielle - Reverdy

- Sandburg

- Duhamel - Romains

- Giraudoux - Jouhandeau

- Cassirer

- Harlem - Langston Hughes

- Lovecraft

- Zamiatine

- Svevo - Pirandello

- TS Eliot

- W.Benjamin

- Chesterton

- 1930-1940

- 1940-1950

- 1940s

- Chandler

- Sartre

- Beauvoir

- Mounier

- Borges

- McCullers - O'Connor

- Camus

- Horkheimer - Adorno

- Cela

- Wright

- Bellows - Hopper - duBois

- Gödel - Türing

- Bogart

- Trevor

- Brecht

- Bataille - Michaux

- Merleau-Ponty - Ponge

- Simenon

- Aragon

- Algren - Irish

- Mead - Benedict - Linton

- Vogt - Asimov

- Orwell

- Montherlant

- Buzzati - Pavese

- Lewin - Mayo - Maslow

- Fallada

- Malaparte

- Bloch

- Canetti

- Lowry - Bowles

- Koestler

- 1950-1960

- 1950s

- Moravia

- Rossellini

- Nabokov

- Cioran

- Arendt

- Aron

- Marcuse

- Packard

- Wright Mills

- Vian - Queneau

- Quine - Austin

- Blanchot

- Sarraute - Butor - Duras

- Ionesco - Beckett

- Rogers

- Dürrenmatt

- Sutherland - Bacon

- Peake

- Durrell - Murdoch

- Graham Greene

- Kawabata

- Kerouac

- Bellow - Malamud

- Martin-Santos

- Fanon - Memmi

- Riesman

- Böll - Grass

- Baldwin - Ellison

- Bergman

- Tennessee Williams

- Bradbury - A.C.Clarke

- Erikson

- Bachmann - Celan - Sachs

- Rulfo-Paz

- Carpentier

- Achébé - Soyinka

- Pollock

- Mishima

- Salinger - Styron

- Fromm

- 1960-1970

- 1960s

- Ricoeur

- Roth - Elkin

- Lévi-Strauss

- Burgess

- Pynchon - Heller - Toole

- Ellis

- U.Johnson - C.Wolf

- J.Rechy - H.Selby

- Antonioni

- T.Wolfe - N.Mailer

- Capote - Vonnegut

- Plath

- Burroughs

- Veneziano

- Godard

- Onetti - Sábato

- Sillitoe

- McCarthy - Minsky

- Sagan

- Gadamer

- Martin Luther King

- Laing

- P.K.Dick - Le Guin

- Lefebvre

- Althusser

- Lacan

- Foucault

- Jankélévitch

- Goffman

- Barthes

- Cortázar

- Grossman

- Warhol

- McLuhan

- 1970-1980

- 1980-1990

- 1990-2000

- Lectures XXIe

- Promenades

- Paysages

- Contact

- 1920s

- Breton

- Tanguy - Ernst

- Eluard

- Jacob - Cocteau

- Gramsci - Lukacs

- Woolf

- Valéry

- Alain

- Mansfield

- Lawrence

- Bachelard

- Zweig

- Larbaud - Morand

- Hesse

- Döblin

- Musil

- Mann

- Colette

- Mauriac

- MartinDuGard

- Spengler

- Joyce

- Pabst

- S.Lewis

- Dreiser

- Pound

- Heisenberg

- Supervielle - Reverdy

- Sandburg

- Duhamel - Romains

- Giraudoux - Jouhandeau

- Cassirer

- Harlem - Langston Hughes

- Lovecraft

- Zamiatine

- Svevo - Pirandello

- TS Eliot

- W.Benjamin

- Chesterton

Physique de l'Univers, Champs & Energie - Max Planck (1858-1947) - Albert Einstein (1879-1955) - Thedov Kaluza (1885-1954) - Oskar Klein (1894-1977) - Werner Heisenberg (1901-1976) - Erwin Schrödinger (1887-1962) - Ernest Rutherford (1871-1937) - Niels Bohr (1885-1962) - Linus Pauli (1900-1938) - Paul Dirac (1902-1984) - James Chadwick (1891-1974) - Hideki Yukawa (1907-1981) - Carl Anderson (1905-1991) - Richard Feynman (1918-1988) - Peter Higgs (1929)...

Last update: 09/09/2017

La théorie d'Einstein va confirmer les plus grands philosophes scientifiques du temps - Mach, Poincaré et Duhem dans leur conviction que la représentation que la science se fait de l'univers n'est pas une représentation déterminée de la structure des choses en soi, mais plutôt une construction intellectuelle, choisie parmi d'autres en raison de son économie et de sa simplicité, qui ne prétend pas décrire littéralement la réalité, mais seulement entrer en contact avec elle en fournissant les instruments symboliques pour la prévision des observations futures à partir des observations présentes.

On a supposé, de façon simpliste et avec les plus infimes motifs, que la relativité d'Einstein impliquait un «relativisme» généralisé, une négation de toute vérité objective. Bien que ceci ne soit pas justifié, il reste que deux concepts newtoniens fondamentaux ont été mis en question. La découverte de la constitution électrique de la matière semble, comme le dit Russell, dématérialiser la matière, et la relativité, de son côté, semble récuser le privilège souvent réclamé par la physique de donner la description objective de la nature ultime de l'univers....

Einstein's theory will confirm the greatest philosophers of science of the time - Mach, Poincaré and Duhem - in their conviction that the representation that science makes of the universe is not a determined representation of the structure of things in itself, but rather an intellectual construction, chosen among others because of its economy and simplicity, which does not pretend to describe reality literally, but only to get in touch with it by providing the symbolic instruments for the prediction of future observations from present observations.

It has been assumed, in a simplistic way and with the most minute motives, that Einstein's relativity implies a generalized "relativism", a negation of any objective truth. Although this is not justified, the fact remains that two fundamental Newtonian concepts have been called into question. The discovery of the electrical constitution of matter seems, as Russell says, to dematerialize matter, and relativity, for its part, seems to deny the privilege often claimed by physics of giving the objective description of the ultimate nature of the universe....

La teoría de Einstein confirmaría a los más grandes filósofos de la ciencia de la época -Mach, Poincaré y Duhem- en su convicción de que la representación científica del universo no es una representación determinada de la estructura de las cosas en sí misma, sino una construcción intelectual, elegida entre otras por su economía y simplicidad, que no pretende describir la realidad literalmente, sino sólo entrar en contacto con ella proporcionando los instrumentos simbólicos para la predicción de las observaciones futuras a partir de las observaciones presentes.

Se ha asumido, de forma simplista y con los motivos más minúsculos, que la relatividad de Einstein implica un "relativismo" generalizado, una negación de cualquier verdad objetiva. Aunque esto no está justificado, el hecho es que se han puesto en duda dos conceptos newtonianos fundamentales. El descubrimiento de la constitución eléctrica de la materia parece, como dice Russell, desmaterializar la materia, y la relatividad, por su parte, parece negar el privilegio que suele reclamar la física de dar la descripción objetiva de la naturaleza última del universo....

Incertitude, discontinuité, probabilisme, indéterminisme fondamental, c'est bien malgré eux que les physiciens du XXe siècle soulèvent de telles conséquences, l'Univers, au fond notre existence, repoussant la limite de ce qu'il peut appréhender, découvre un monde partiellement inobservable - "la science ne peut résoudre l'ultime mystère de la nature parce qu'en dernière analyse nous faisons nous-mêmes parties du mystère que nous essayons de résoudre" (Max Planck) - C'est dans les années 1930 que les travaux d'Erwin Schrödinger, de Paul Dirac et de Werner Heisenberg posent les bases de la physique des particules moderne. Depuis la théorie de la gravitation universelle d'Isaac Newton, au XVIIe siècle, qui entre dans notre champ de perception, ne serait-ce que parce qu'elle nous permet de prédire et de vérifier, par l'observation, positions et vitesses de la pomme tombant d'un arbre ou le mouvement des planètes, puis, au XIXe siècle, la théorie des champs électromagnétiques d'un James Maxwell, qui reconstruit notre perception au travers des multiples objets de communication et appareils électroniques que nous inventons et utilisons, nous comprenons que nous baignons dans un champ gravitationnel et un océan d'ondes électromagnétiques, - que nous avons pour une grand part construites. Le XXe siècle franchit une étape critique avec notamment la théorie de la relativité générale d'Einstein : ce sont alors les instruments scientifiques qui prennent le relais de notre perception, voire de notre compréhension, ils simulent, vérifient, prédisent. La dilatation du temps a par exemple été nombre de fois vérifiée dans le comportement des rayons cosmiques, les équations de la relativité générale nous prédisent l'existence de ces fameux trous noirs qui piègent la lumière, et la réalité elle-même dans son exploration tombe sous la dépendance de nos méthodes d'observation. Or, cosmologie, physique, philosophie, psychologie, biologie s'expriment en des termes si proches, soulèvent des interrogations comparables, posent des hypothèses similaires, que l'on peut effectivement étendre la quête d'unification des phénomènes physiques à cette extraordinaire symbiose de l'humain et de l'univers, de l'humain et de la vie, de l'humain et de l'existence. Quand le physicien Michael Faraday réalise, le premier, en 1830, l'importance du concept de "champ", forme d'existence de la matière, capable d'emmagasiner de l'énergie ou de l'impulsion, le monde psychologique apprend à lire l'humain en termes de complexes, d'inconscient et de libido, d'univers énergétique qui utilise aussi des termes d'ondes, fréquences, vibrations. Notre corps physique est composé de cellules organiques, mais aussi de cellules photoélectriques assurant un contact plus fin avec les autres humains et avec les règnes animal et végétal, et ces enveloppes corporelles constituent autant de champs électromagnétiques. Notre premier mode de communication est, dira-t-on, énergétique, et la médecine ayurvédique, la plus ancienne médecine connue, nous décrit en termes d'enveloppes successives, complexifiant ce corps physique qui cherche son chemin au travers de nos émotions, attitudes et comportements. Physique de l'univers, physique du corps, physique de la pensée ou de la conscience, toutes les particules qui peuplent l'univers, toutes les forces qui agissent en elles, toutes les formules ou théories qui tentent de décrire la complexe matérialité de notre Univers, peuvent-elles nous aider à traduire notre existence dans cet Univers?

"Certes, comme l”affirmait Camus (via Le Mythe de Sisyphe), les progrès en physique concernant le nombre de dimensions de l`espace, par exemple, ou les progrès en neuropsychologie sur la structure du cerveau, ou ceux dans toute autre discipline scientifique, peuvent représenter des détails importants, mais leurs effets sur notre appréciation de la vie et de la réalité restent minimes. Certes, la réalité est ce que l'on pense qu'elle est ; la réalité nous est révélée par nos propres expériences. Cette vision de la réalité est partagée, dans une certaine mesure, par beaucoup d`entre nous, au moins de manière implicite. Moi-même je pense de cette manière dans ma vie de tous les jours ; on se laisse aisément séduire par le visage que la nature révèle directement à nos sens. Et pourtant, depuis que j'ai découvert le texte de Camus voici plusieurs dizaines d'années, j'ai appris que la science moderne ne conte pas la même histoire. La grande leçon des recherches scientifiques de ces cent dernières années est que l'expérience humaine se révèle souvent trompeuse quant à la véritable nature de la réalité. Juste sous la surface de la vie quotidienne réside un monde à peine reconnaissable. Les disciples des sciences occultes, les adeptes d'astrologie ou tous ceux qui sont fidèles à des principes religieux concemant une réalité au-delà de nos observations ont, avec des points de vue variés et depuis fort longtemps, atteint une conclusion analogue. Mais ce n'est pas à cela que je pense. J'ai en tête le travail d'inventeurs de génie, de chercheurs infatigables - femmes et hommes de science - qui ont épluché l'oignon cosmique couche par couche, énigme par énigme, pour dévoiler un Univers tout à la fois surprenant, inconnu, passionnant, élégant et complètement différent de tout ce que quiconque aurait pu imaginer. Ces développements sont loin de n'être que des détails. Les grandes découvertes en physique nous ont contraints, et nous contraignent aujourd”hui encore, revoir complètement notre conception de l'Univers. Pour ma part, je reste persuadé, autant que je l'étais il y a toutes ces années, que Camus avait fait le bon choix en considérant la valeur de la vie comme la seule vraie question. Mais les progrès de la la vision que nous offre notre quotidien revient à admirer un Van Gogh à travers un fond de bouteille. La science moderne a anéanti les uns après les autres tous les indices issus de nos perceptions rudimentaires, prouvant ainsi que ces demières nous livrent souvent une conception voilée de notre monde. Ainsi, bien que Camus ait relégué les questions physiques au rang de questions secondaires, pour ma pan, j'ai réussi à me convaincre qu'elles sont en fait primordiales. À mon sens, la réalité physique permet tout à la fois de définir un cadre et d'offrir l'éclairage nécessaire pour s'attaquer à la grande question de Camus. Tenter d'estimer la valeur de la vie sans compter avec les progrès de la physique moderne reviendrait à se battre dans le noir avec un ennemi que l'on ne connaît pas. En approfondissant notre compréhension de la véritable nature de la réalité physique, on précise notre image de nous-même et notre expérience de l'Univers.... Brian Greene, La Magie du Cosmos, L'espace, le temps, la réalité: tout est à repenser - The Fabric of the Cosmos, 2004).

Les années 1924-1930 voient naître la physique quantique, portée par une extraordinaire générations de chercheurs. L'hypothèse de l'existence des atomes est très ancienne. Lorsque Démocrite au Ve siècle suggère que le monde est composé d'atomes se mouvant dans le vide, il imagine que tous les objets sont constitués de différents agencements d'atome, et sans doute parvient à l'intuition, via le concept atomique, de la nature indivisible de l'existence. Mais voici qu'avec la Science qui se construit à la fin du XVIIIe siècle, l'interrogation s'inverse et devient : à quoi arrive-t-on quand on scinde indéfiniment la matière ? Des théories simples mais prématurées ont été proposées au cours des siècles, mais la question était complexe et n'a été que peu à peu éclaircie. C'est un chimiste, Antoine Lavoisier (1778) qui, cherchant à comprendre les principes de la combustion, comprend que celle-ci n'est que le processus par lequel l'oxygène de l'air se combine à d'autres éléments, et identifie ainsi des substances chimiques pures impossibles à diviser en d'autres substances. Dans les années 1880, Ludwig Boltzmann (1844-1906) développe la théorie cinétique des gaz et montre ainsi le rôle capital des molécules et des atomes en science ohysique. En bref, expériences et raisonnement ont fait découvrir que, dans les conditions physiques qui règnent sur la Terre, la plupart des corps sont composés de molécules, entités relativement stables, elles-mêmes composées d'atomes ; il existe une centaine d'atomes différents (les « éléments ›› de la chimie), de l'hydrogène à l'uranium, dont les masses vont de 1 à 240. La combinaison d'au moins deux atomes, semblables ou non, grâce à leur aptitude à se lier entre eux, donne naissance à l'extraordinaire diversité des molécules et des cristaux. La composition des molécules et l'étude de leurs réactions font l'objet de la chimie (Introduction de l'idée de molécule et d'atome (1814, Avogadro, Ampère), Classification périodique des éléments (1869, D. Mendeleïev).. Une petite centaine d'atomes différents (leur existence a été définitivement admise autour des années 1900), cela paraît encore beaucoup. L'étude de la radioactivité, lors de laquelle les atomes changent de nature, et celle de la façon dont les atomes chauffés émettent de la lumière ont fait comprendre que les atomes eux-mêmes ne sont pas des objets simples et élémentaires. Ils contiennent des particules légères, les électrons, tous identiques et munis d'une charge électrique négative, ainsi qu'un noyau, beaucoup plus lourd et de charge positive. Chaque type de noyau est caractéristique d'un élément et il renferme la quasi-totalité de la masse atomique. Une expérience réalisée par Rutherford en 1911 a été le modèle de nombreuses expériences de physique. Elle a montré que, paradoxalement, le volume occupé dans l'atome par le lourd noyau est beaucoup plus faible que celui dans lequel s'agitent les légers électrons animés, sous l'attraction électrique des noyaux, d'un mouvement permanent. Il était dès lors tentant de considérer les atomes comme de minuscules systèmes solaires, les électrons tenant lieu de planètes tournant autour d'un noyau central. La réflexion sur la nature des forces agissant entre électrons et noyaux, le fait que les électrons ne se collent pas étroitement aux noyaux positifs, qui pourtant les attirent, ont conduit au concept de l'atome de Bohr. Dans ce modèle, et contrairement à ce qui se passe pour les planètes, il faut admettre que les électrons ne peuvent occuper que certaines orbites particulières. La théorie élaborée à cette occasion, la physique quantique, forme le cadre conceptuel utilisé pour décrire les phénomènes à l'échelle des atomes et des noyaux et aux échelles encore plus petites mises en jeu dans la physique des particules...

Alors que la fameuse constante gravitationnelle de Newton, "G", n'est pas une fin en soi pour tenter de construire une pensée globale de l'Univers, les constantes de Boltzmann (1872) et de Planck (1900) traduisent les premières limites, voire les contraintes, de cette fenêtre possible ouverte sur la compréhension de notre monde, de l'infiniment petit à l'infiniment grand. Ludwig Boltzmann (1844-1906) part du microscopique (les atomes) pour établir les lois de la thermodynamique macroscopique et mesurer le degré de désordre de tout système (l'entropie) : les propriétés de la matière résultent des lois fondamentales du mouvement et les règles statistiques de la probabilité selon le fameux facteur de proportionnalité dit constante de Boltzmann. Ce que traduit celle-ci, ou traduira dans toutes ses conséquences des décennies plus tard, c'est que l'accroissement d'entropie qui survient quand on décrit un système dans un contexte macroscopique, correspond à une perte d'information...

En 1900, Max Planck (1858-1947), cherchant à comprendre le rayonnement des corps noirs (des objets absorbant intégralement l'énergie électromagnétique qu'ils reçoivent) en calculant le spectre de rayonnement moyen et la répartition de l'entropie, aboutit à concevoir la frontière entre notre monde et le domaine quantique que va construire la science de ce début du XXe siècle. La formule, E = hf relie la plus petite quantité d'énergie E emportée par un rayonnement électromagnétique à sa fréquence f, via la valeur h d'une constante qui exprime le seuil d'énergie minimum que l'on puisse mesurer sur une particule. Il définit ainsi une échelle fondamentale, limite au-delà de laquelle le monde ne serait qu'une sorte de bouillonnement quantique dans lequel des particules virtuelles peuvent surgir du vide pour se désintégrer aussitôt. Associée à ce schéma, la plus petite mesure de temps à laquelle nous puissions avoir accès: ici aussi, au-delà de cette limite les lois physique cesseraient d'être valides. Nous quittons ainsi la mécanique classique de Newton, la certitude et la précision, pour un monde d'incertitude dans lequel s'impose une description probabiliste de l'Univers..

1900, Max Planck (1858-1927) introduit, presque malgré lui, le discontinu dans la description de phénomènes élémentaires, plus précisément dans celle des interactions : butant sur les difficultés d'interprétation du "rayonnement du corps noir", Planck introduit l'idée des paquets d'énergie ou quanta, définit la lumière comme un ensemble de quanta...

Dans la première moitié du XIXe siècle, Faraday avait montré que les champs électriques et magnétiques étaient étroitement liés, mais c'est James Clerk Maxwell qui pose les bases mathématiques, en 1873, de la "théorie électromagnétique" : champs électriques et magnétiques existent en l'absence de toutes charges ou courants électriques, la variation du champ électrique produit un champ magnétique, la variation de ce dernier produit à son tour un champ électrique, et ces champs qui s'auto-entretiennent décrivent la propagation d'une onde électromagnétique. Lors d'une communication par téléphone sans fil, l'onde électromagnétique est générée par l'antenne et se propage pour arriver au récepteur du correspondant. ) ou encore quand la lumière se propage depuis la source qui l'a engendrée jusqu'à nos yeux. La théorie électromagnétique de Maxwell, toujours utilisée pour construire des systèmes de télécommunication terrestre ou par satellite, décrit un système qui a une infinité de degrés de liberté car un champ a un nombre infini de variables, la valeur d'un champ variant pour chaque point de l'espace et à chaque instant. Les lois quantiques, que physiciens vont chercher à introduire dans la théorie de Maxwell, décrivent un nombre constant et fini de particules. Avec l'étude du rayonnement du corps noir, Max Planck émet en 1900 l'hypothèse des quanta et fait intervenir l'interaction entre le champ électromagnétique et la matière, mais reste confronté à la problématique formalisation des systèmes qui possèdent infinité de degrés de liberté : on sait décrire selon les lois de la physique classique un système qui a une infinité de degrés de liberté, ainsi par exemple une corde qui vibre : elle a des modes d'oscillation, une fréquence de base et des multiples ou harmoniques. Planck ne parviendra jamais à décrire de façon satisfaisante sa découverte. Ici, le système possède un nombre fini de degrés de liberté. C'est Dirac qui, en 1928, expliquera comment rendre quantique un système qui a une infinité de degrés de liberté...

1905, Albert Einstein (1879-1955), avec la théorie de la Relativité restreinte, modifie notre perception des lois de la physique. Si la vitesse de la lumière dans l'espace vide est constante et si les lois de la physiques sont les mêmes pour tous les observateurs, alors il ne peut exister de temps ou d'espace absolu, les observateurs en mouvement relatif perçoivent différemment le temps et l'espace (relativité de la simultanéité). Dans un second article, Albert Einstein traite de l'effet photoélectrique (Hertz, 1887) et, développant l'idée de quantification de la lumière de Max Planck, considère que le quantum est un objet bien réel : il utilise ce concept pour introduire l'idée du photon et va considérer la lumière comme une vibration électromagnétique et comme composée de petits grains d'énergie. L'étude de l'émission et de l'absorption des ces photons aboutit à la description quantique des atomes. L'introduction du concept de photon bouleverse de même la notion de "champ" : avant la formulation de la physique quantique, les particules et les champs étaient considérés comme des entités liées, - des particules qui ne réagissent à aucun champ de force ne sont pas observables -, mais distinctes, les particules possèdent certaines caractéristiques intrinsèques (comme la masse et la charge électrique) et produisent les champs (gravitationnels et électromagnétiques) qui emmagasinent et peuvent transporter de l'énergie. Avec Albert Einstein, le champ électromagnétique n'a pas son énergie distribuée d'une façon continue dans l'espace, et le photon, "quantum du champ électromagnétique", transporte à la fois l'énergie et la quantité de mouvement du champ. Dans un troisième article, la célèbre équation E=mc2, selon laquelle une toute petite masse peut se transformer en une énorme quantité d'énergie, et inversement, modifie totalement notre vision de la matière : la matière est interchangeable avec l'énergie, l'énergie restant cette notion bien étrange que toute matière ou phénomène naturel produit, que contient en quantité constance notre Univers, et que personne ne sait encore définir...

1911, Ernest Rutherford (1871-1937), charismatique expérimentateur, propose son modèle planétaire de l'atome, composé à 99,9% de vide, et met en évidence l'existence des noyaux atomiques. Les atomes ne pouvant être observés à la lumière ordinaire, c'est en les bombardant par des particules plus petites qu'ils révèlent des noyaux lourds et compacts et des électrons légers et mobiles. C'est en 1906 que Joseph John Thomson (1856-1940) avait découvert, à la surprise générale, l'électron et montrer ainsi que les atomes étaient décomposables.

1913, Niels Bohr (1885-1962) reprend les travaux de Rutherford et propose son modèle atomique, dans lequel les électrons dessinent des orbites précises autour du noyau et, en passant d'un niveau d'énergie à un autre, émettent ou absorbent des quantas de lumière, les photons. Ici électromagnétisme et matière se rejoignent. Arnold Sommerfeld (1868-1951) améliore en 1916 le modèle en tenant compte de la très grande vitesse des électrons. Mais il faudra attendre les années 1920 pour que la mécanique quantique se voie enfin dotée d'un cadre mathématique solide, et Arthur Holly Compton (1892-1962) pour démontrer la réalité physique des photons (1922)...

1915-17, Albert Einstein produit un modèle cosmologique fondé sur la relativité générale, de fait une théorie de la gravité : les corps dotés d'une masse courbent l'espace-temps, d'où leur attraction gravitationnelle. La lumière elle-même peut être incurvée par la poussée gravitationnelle générée par des objets interstellaires qu'elle rencontre. Hermann Minkowski (1864-1909) avait auparavant prolongé les travaux de Hendrik Lorentz (1853-1928, les transformations de Lorentz, première synthèse de la mécanique newtonienne et de la théorie du champ de Maxwell) pour réunir dans un continuum espace-temps les deux dimensions jusque-là séparées. Au final, la force, grand vecteur de la mécanique classique, cède dorénavant la place à un "champs" régi par des équations différentielles. Et c'est le mathématicien Karl Schwarzschild (1873-1916) qui, en utilisant l'équation tensorielle d'Einstein, décrit le champ gravitationnel particulier produit par une masse sphérique symétrique, telle que Soleil-Terre, et suggère l'effondrement possible d'une étoile sur elle-même...

Participants au Congrès Solvay de 1927 sur la mécanique quantique. Photographie de Benjamin Couprie pour le compte de l'Institut international de physique Solvay. De l'arrière vers l'avant et de gauche à droite : Auguste Piccard, Émile Henriot, Paul Ehrenfest, Édouard Herzen, Théophile de Donder, Erwin Schrödinger, Jules-Émile Verschaffelt, Wolfgang Pauli, Werner Heisenberg, Ralph H. Fowler, Léon Brillouin, Peter Debye, Martin Knudsen, William Lawrence Bragg, Hendrik Anthony Kramers, Paul Dirac, Arthur Compton, Louis de Broglie, Max Born, Niels Bohr, Irving Langmuir, Max Planck, Marie Curie, Hendrik Antoon Lorentz, Albert Einstein, Paul Langevin, Charles Eugène Guye...

1926, Erwin Schrödinger (1887-1961) conçoit la mécanique ondulatoire et formule une fonction d'onde décrivant l'évolution d'un électron au fil du temps, posant ainsi les bases de la mécanique quantique. En 1924, Louis de Broglie prouve que la matière se comporte à la fois comme une onde et comme une particule, et surprend la communauté scientifique en postulant l'existence d'une onde sans en avoir posé la moindre équation : des expériences valident l'hypothèse, Erwin Schrödinger forge alors une nouvelle équation en reprenant les lois de la mécanique classique portant sur l'énergie et la quantité de mouvement, auxquelles il va intégrer la constante de Planck et la loi de Broglie qui lie longueur d'onde et quantité de mouvement. L'équation ainsi constituée exprime ainsi une amplitude de probabilité, si les électrons se comportement comme des ondes, une fonction d'onde permet de calculer la probabilité de détecter un électron à un point particulier de l'espace-temps. Avec Dirac, Schrödinger nous permet d'approfondir notre connaissance des orbitales et couches des atomes, nuages de probabilité plus que circuits bien tracés. Plus globalement, l'équation de Schrödinger décrit par des nombres complexes l'évolution d'un système quantique dans le temps.

1927, partant de la fonction d'onde de Schrödinger, Werner Heisenberg (1901-1976) formule son "principe d'incertitude" (uncertainty principle) et, avec Bohr, propose leur fameuse "interprétation de Copenhague" sur la façon dont les événements quantiques influent sur le monde macroscopique. On ne peut, énonce Heisenberg, déterminer simultanément la position et la vitesse d'une particule, et plus nous nous montrerons capables de déterminer sa position, moins sa vitesse pourra être connue, et réciproquement. La physique quantique postule ainsi un modèle de réalité, via la dualité onde-particule, dans lequel la structure de l'Univers est habitée par une notion d'incertitude fondamentale. Et de plus, les particules quantiques elles-même sont autant affectées par la lumière que par nos observations, nos mesures, nous perturbons inéluctablement le monde que nous observons. C'est par notre "observation" que la particule se fait onde. Mais cela signifie-t-il que nous ne pouvons rien déterminer tant que l'on n'a pas effectué de mesure? Schrödinger répondra à ce qu'il juge un paradoxe absurde par la fameuse expérience de pensée, "le chat de Schrödinger", qui suscitera bien des interprétations...

1928, Paul Dirac (1902-1984) énonce le "principe d'exclusion" (un seul électron par orbite), introduit l'électrodynamique quantique et, avec Werner Heisenberg, travaillent au développement de la théorie quantique des champs. Si Dirac échoue dans sa tentative de d'unifier mécanique quantique et relativité générale, il est amené à corriger l'équation d'onde de Schrödinger pour tenir compte des effets relativistes: cette nouvelle équation prédit l'existence de l'antimatière (à chaque particule correspond une antiparticule, l'existence du positron, antiparticule de l'électron, sera confirmée en 1932 par Carl Anderson...

1932, James Chadwick (1891-1974) découvre le neutron : les seules particules connues vers 1920 étaient le proton et l'électron, et c'est avec la mise en évidence du neutron que l'on peut enfin expliquer les masses des noyaux. De plus, cette découverte conduira en 1954 à la "théorie de jauge", base du modèle standard...

1934, Enrico Fermi (1901-1954) propose une interaction nouvelle, dont la portée est presque nulle et l'intensité très faible, l' "Interaction faible". Au début du XXe siècle, les physiciens avaient découvert la radioactivité (certains éléments chimiques des plus instables se transformaient en un autre élément chimique, d'une case à droite ou à gauche dans le tableau périodique de Mendeleïev, en émettant des particules). La radioactivité β était une forme particulière de radioactivité et au milieu des années 1930, comprenant mieux la structure du noyau atomique, Enrico Fermi établit le premier modèle théorique de la désintégration β : la transformation du neutron en proton, électron et antineutrino est due à une nouvelle interaction, dite "faible"...

1935, Hideki Yukawa (1907-1981) propose la théorie "mésonique" des forces nucléaires fortes, la question est alors de déterminer la force qui tient ensemble les nucléons en dépit de la répulsion électrique entre les protons : pour y répondre est postulée l'existence d'une interaction forte par échange d'une particule entre les nucléons, le méson (il sera renommé en "pion" en 1947 après avoir été identifié dans une interaction de rayon cosmique par Cecil Powell (1903-1969)).La portée de l'interaction forte est courte, de l'ordre des dimensions du noyau atomique, au-delà desquelles elle devient presque nulle (au contraire de l'interaction électromagnétique qui agit à de grandes distances).

1936, Carl Anderson (1905-1991) découvre dans le rayonnement cosmique une particule inattendue, très similaire à l'électron, mais avec une masse environ 200 fois plus grande, le "muon". On ne connaissait alors qu'un petit nombre de particules élémentaires, l'électron, le photon, le proton, le neutron, l'hypothétique neutrino de Pauli, le mystérieux méson de Yukawa, ces deux derniers n'ayant alors pas encore été mis en évidence expérimentalement.

1939, Linus Pauling (1901-1994) explique la chimie en utilisant la physique quantique : la nature de la liaison chimique reflète le comportement quantique des électrons, au sein d'une molécule..

1942, Robert Oppenheimer (1904-1967), spécialiste des étoiles à neutrons et des trous noirs, mène le projet Manhattan qui vise à fabriquer la bombe atomique: c'est l'aboutissement des expériences réalisées autour de la fission nucléaire qui laisse entrevoir un immense potentiel énergétique (John Cockcroft, Ernest Walton, 1932) et du processus de réaction en chaîne (Leo Szilard, 1939), mais c'est aussi une nouvelle étape qui est franchie, qui pose les questions de la responsabilité de l'humain et des finalités de la science qu'il développe...

1948, "la méthode de l'intégrale de chemins" (the path integral formulation of quantum mechanics), les diagrammes de Richard Feynman (1918-1988) - les particules subatomiques sont particulièrement difficiles à observer et à visualiser et les physiciens théoriciens travaillaient uniquement avec des formules mathématiques, jusqu'à ce Richard Feynman, pédagogue hors du commun ( "Lectures on physics", 1961–64, "The Character of Physical Law", 1967, "The Meaning of it all: thoughts of a citizen-scientist", 1998, "Surely You're Joking Mr. Feynman", 1985...), ne parvienne à développer une méthode permettant de transcrire les données mathématiques en représentations visuelles, et plus encore fournir les outils intellectuels propres à l'exploration des nouveaux horizons physiques : désormais, une démarche scientifique parvient à nous éviter ce fameux face-à-face du sujet et de l'objet, thème traditionnel de la philosophie mais devenue impasse dans la construction de la démarche du physicien ou du cosmologue. Pour nous représenter la transition d'un système, d'un état initial à un état final, et connaître ensuite l'amplitude de la probabilité de cette transition, le raisonnement consiste tout d'abord à tenter de déterminer tous les chemins indiscernables que peut emprunter cette transition, puis déduire son amplitude de probabilité comme la somme complexe de toutes les amplitudes associées aux différents chemins possibles. Dans cette approche, une particule n'a plus une seule et unique trajectoire, elle suit au contraire toutes les trajectoires possibles de l'espace-temps, et à chacun de ces chemins est associé un couple, grandeur de l'onde / situation dans sa phase. Ici, le réel est donc par essence considéré comme totalement indéterminé, et c'est bien tous les modes d'existence envisageable de ce réel qui vont faire l'objet d'une construction et d'une représentation via des variables dynamiques.

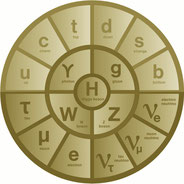

1954, le "modèle standard" (The Standard Model), l’Univers serait fait de douze constituants de base, ou particules fondamentales, et gouverné par quatre forces fondamentales (la force forte, la force faible, la force électromagnétique et la force gravitationnelle) - Dans les années 1950, le perfectionnement des accélérateurs de particules permet d'étudier un grand nombre de réactions nucléaires et de découvrir de nouvelles particules élémentaires, et ces découvertes, produites pour leur grande part dans les processus d'interaction forte, se comptent par centaines. Aujourd'hui toute matière est considérée comme formée de particules appelées "fermions", qui sont des objets quantiques. Ils agissent les uns sur les autres (attraction, répulsion, désintégration...) selon des forces (ou interactions) qui, elles-mêmes, sont transmises par d'autres particules dites bosons, chaque force possédant ses bosons spécifiques. Les connaissances actuelles dans ce domaine sont rassemblées dans une théorie physique dite "modèle standard", résultat certes encore imparfait des efforts accomplis par les physiciens pour mettre en évidence l'unité profonde de la matière, en dépit de la variété des forces qui y règnent. Dans ce modèle, les "briques" de matière, les fermions élémentaires, sont les quarks (qui s'assemblent pour former des fermions composés comme les protons et les neutrons) et les leptons (l'électron, le neutrino, la particules la plus abondante de l'Univers, et les très instables muon et tauon). Et ils interagissent par l'intermédiaire de la "force électrofaible", d'une part, dont les bosons médiateurs sont le photon et trois bosons de la "force de couleur", d'autre part, dont les bosons sont appelés "gluons". La force de couleur n'a rien à voir avec une quelconque teinte des particules mais c'est par simple analogie que le mot couleur a été choisi pour désigner cette nouvelle sorte d'interaction qui maintient les quarks étroitement soudés ensemble dans les protons et les neutrons.

1964, le Boson de Higgs - Dans années 1960, il apparaît que le "vide" n'est jamais réellement vide. Si en physique classique, les champs électrique et magnétique sont des entités continues qui se propagent dans l'espace et qui évoluent sans heurt, la mécanique quantique, elle, rejette la notion de continuum : les champs deviennent des ensembles de "particules de champ", où la puissance du champ est fonction de la densité de ses particules. Les particules traversant un champ sont ainsi influencées par celui-ci via l'échange d'intermédiaires qui entrent dans toutes les interactions fondamentales, les "bosons de jauge" : et c'est ainsi que les particules élémentaires vont acquérir une masse, que le "modèle standard" est validé, et que l'on comprend pourquoi différentes forces existent entre les particules. C'est Peter Higgs (1929) qui postule ce mécanisme, le "champ de Higgs", permettant à un champ de force de produire à la fois des bosons de jauge à faible et forte masse. Enfin, Steven Weinberg (1933) et Abdus Salam (1926-1996) complètent et finalisent en 1967 le "modèle atomique" en ajoutant à celui-ci le mécanisme de Higgs qui confère ainsi de la masse aux particules...

La vocation de la physique consiste, disait Einstein, à bâtir "une conception unifiée de l'univers" autour du plus petit nombre possible de formules mathématiques. Et le concepteur de la théorie de la relativité restreinte puis générale a conduit son projet en reformulant les présupposés de la mécanique rationnelle qui le précédaient, les englobant dans sa nouvelle conception tout en rendant compte mathématiquement de leur approximation. En chemin, si Einstein rend possible la conception d'un modèle standard de la cosmologie, il se heurte, comme la physique des particules, à cette fameuse interaction gravitationnelle, à laquelle toute notre existence est rattachée, et que l'on ne peut omettre sous prétexte qu'elle serait négligeable au regard des autres interactions fondamentales. Mais au-delà du raisonnement, de la construction, de la marche continue vers une plus grande abstraction de la vision du monde, malgré toutes les précautions de conceptualisation et d'expérimentation, physiciens et cosmologues ne peuvent se borner, en toute humilité, comme le souhaiter les positivistes, aux constats des mesures effectuées, l'élan vital de la connaissance soulève les interrogations et les paradoxes les plus invraisemblables, aux limites des possibilités de raisonnement de la Science, de toute la Science, Einstein lui-même s'était interdit d'imaginer par exemple qu'une vitesse puisse dépasser celle de la lumière : l'esprit , quoique l'on dise, quoique l'on fasse, semble inscrit au plus profond de la matière...