- INTRO

- Lectures XVIIe-XVIIIe

- Lectures XIXe-XXe

- 1820-1840

- 1840-1860

- 1860-1880

- 1880-1900

- 1900-1910

- 1910-1920

- 1920-1930

- 1920s

- Breton

- Tanguy - Ernst

- Eluard

- Jacob - Cocteau

- Gramsci - Lukacs

- Woolf

- Valéry

- Alain

- Mansfield

- Lawrence

- Bachelard

- Zweig

- Larbaud - Morand

- Hesse

- Döblin

- Musil

- Mann

- Colette

- Mauriac

- MartinDuGard

- Spengler

- Joyce

- Pabst

- S.Lewis

- Dreiser

- Pound

- Heisenberg

- Supervielle - Reverdy

- Sandburg

- Duhamel - Romains

- Giraudoux - Jouhandeau

- Cassirer

- Harlem - Langston Hughes

- Lovecraft

- Zamiatine

- Svevo - Pirandello

- TS Eliot

- W.Benjamin

- Chesterton

- 1930-1940

- 1940-1950

- 1940s

- Chandler

- Sartre

- Beauvoir

- Mounier

- Borges

- McCullers - O'Connor

- Camus

- Horkheimer - Adorno

- Cela

- Wright

- Bellows - Hopper - duBois

- Gödel - Türing

- Bogart

- Trevor

- Brecht

- Bataille - Michaux

- Merleau-Ponty - Ponge

- Simenon

- Aragon

- Algren - Irish

- Mead - Benedict - Linton

- Vogt - Asimov

- Orwell

- Montherlant

- Buzzati - Pavese

- Lewin - Mayo - Maslow

- Fallada

- Malaparte

- Bloch

- Canetti

- Lowry - Bowles

- Koestler

- 1950-1960

- 1950s

- Moravia

- Rossellini

- Nabokov

- Cioran

- Arendt

- Aron

- Marcuse

- Packard

- Wright Mills

- Vian - Queneau

- Quine - Austin

- Blanchot

- Sarraute - Butor - Duras

- Ionesco - Beckett

- Rogers

- Dürrenmatt

- Sutherland - Bacon

- Peake

- Durrell - Murdoch

- Graham Greene

- Kawabata

- Kerouac

- Bellow - Malamud

- Martin-Santos

- Fanon - Memmi

- Riesman

- Böll - Grass

- Baldwin - Ellison

- Bergman

- Tennessee Williams

- Bradbury - A.C.Clarke

- Erikson

- Bachmann - Celan - Sachs

- Rulfo-Paz

- Carpentier

- Achébé - Soyinka

- Pollock

- Mishima

- Salinger - Styron

- Fromm

- 1960-1970

- 1960s

- Ricoeur

- Roth - Elkin

- Lévi-Strauss

- Burgess

- Pynchon - Heller - Toole

- Ellis

- U.Johnson - C.Wolf

- J.Rechy - H.Selby

- Antonioni

- T.Wolfe - N.Mailer

- Capote - Vonnegut

- Plath

- Burroughs

- Veneziano

- Godard

- Onetti - Sábato

- Sillitoe

- McCarthy - Minsky

- Sagan

- Gadamer

- Martin Luther King

- Laing

- P.K.Dick - Le Guin

- Lefebvre

- Althusser

- Lacan

- Foucault

- Jankélévitch

- Goffman

- Barthes

- Cortázar

- Grossman

- Warhol

- McLuhan

- 1970-1980

- 1980-1990

- 1990-2000

- Lectures XXIe

- Promenades

- Paysages

- Contact

- 1960s

- Ricoeur

- Roth - Elkin

- Lévi-Strauss

- Burgess

- Pynchon - Heller - Toole

- Ellis

- U.Johnson - C.Wolf

- J.Rechy - H.Selby

- Antonioni

- T.Wolfe - N.Mailer

- Capote - Vonnegut

- Plath

- Burroughs

- Veneziano

- Godard

- Onetti - Sábato

- Sillitoe

- McCarthy - Minsky

- Sagan

- Gadamer

- Martin Luther King

- Laing

- P.K.Dick - Le Guin

- Lefebvre

- Althusser

- Lacan

- Foucault

- Jankélévitch

- Goffman

- Barthes

- Cortázar

- Grossman

- Warhol

- McLuhan

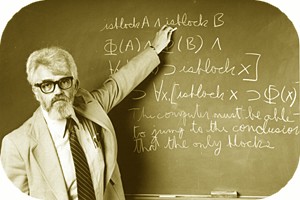

L'Intelligence artificielle - John McCarthy (1927-2011) - Marvin Minsky (1927-2016) - Claude E. Shannon (1916-2001) - Herbert A. Simon (1916-2001) -

Alan Newell (1927-1992) - Edward Feigenbaum (1936) - Noam Chomsky (1928) - Hubert Dreyfus (1929-2017) - Joseph Weizenbaum (1923-2008) - Terry Winograd (1946) - John Searle (1932) - Daniel Clement

Dennett (1942) - …

Last update: 2018/12/12

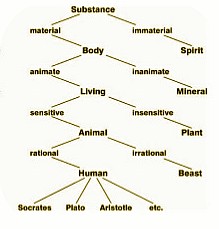

Can Machines Think? Une machine peut-elle penser? - La possibilité de pouvoir formaliser la pensée est un projet qui remonte globalement au XVIIe, qui vit s'opposer les philosophes dits rationalistes, René Descartes (1596-1650) ou Gottfried Wilhelm Leibniz (1646-1716), aux empiristes, comme John Locke (1632-1704) ou David Hume (1711-1776). Un siècle plus tard, George Boole (1815-1864) et Charles Babbage (1791-1871) décrivent la pensée comme une machine logique. La naissance officielle des sciences cognitives date des années 1950, dans le sillage de l'invention de l'ordinateur et des contributions théoriques d'Alan M.Turing (1912-1954, Computing Machinery and Intelligence) et de John von Neumann (1903-1957), jetant les bases d'une véritable révolution scientifique, révolution potentielle qui bénéficie des découvertes successives réalisées en parallèle sur le cerveau. Mais depuis le début des années 2000, le terme de "sciences cognitives" (relayée par les progrès réalisés autour du cerveau) est venu supplanter celui d'intelligence artificielle. Celle-ci, en se spécialisant dans des domaines très spécifiques, tapit désormais notre monde via de multiples systèmes et objets "intelligents" disséminées ici et là au gré de nos activités proprement humaines, souvent invisibles ("As soon as it works, no-one calls it AI anymore", John McCarthy), quant au grand rêve ...

"I believe that what we become depends on what our fathers teach us at odd moments, when they aren’t trying to teach us. We are formed by little scraps of wisdom", a écrit Umberto Eco (Je crois que ce que nous devenons dépend de ce que nos pères nous ont enseigné à des moments singuliers, quand ils n'essayaient pas de nous enseigner. Nous sommes ainsi formés par de petits bouts de sagesse...)

Dès l'apparition des premiers ordinateurs, ressurgit avec une acuité encore inégalée, le vieux rêve ou vieux démon de parvenir à construire des machines capables d'utiliser le langage humain, surpassant ses capacités de raisonnement, de perception, de compréhension, mais aussi d'apprendre, de découvrir, de créer... Avant 1949, les ordinateurs ne disposaient pas d'une condition préalable essentielle à l'intelligence, ils ne pouvaient pas stocker des commandes, mais seulement les exécuter. Les systèmes d'information et les outils qui les portent, vont à partir des années 1950s connaître un extraordinaire développement, laissant augurer une ère nouvelle dont la teneur est encore floue, mais reposant sur une hypothèse fondamentale, la pensée humaine fonctionne comme une "machine logique", penser n'est rien d'autre qu'exécuter une suite de raisonnements dans un ordre déterminé afin de parvenir à une solution donnée, hypothèse déjà suggérée par les travaux d'Alan (l'idée d'une machine universelle, 1936) : "Penser, c'est calculer" (H.A. Simon). "L’origine du développement de l’intelligence artificielle dérive à peu près intégralement d’un mode de compréhension du langage, de la pensée et de l’action qui repose sur les notions de représentation, de formalisme et de manipulations symboliques — elles forment un ensemble de formulations apparentées dont on rend le mieux compte par le biais de la notion d’ordinateur numérique moderne effectuant des programmes organisés autour de l’analyse logique." (T.Winograd, 1989)

La naissance de l'intelligence artificielle est associée à une date, une année, 1956, c'est en effet lors de l'été de cette même année qu'un séminaire organisé à Dartmouth (Hanover, Canada) pose les fondements de ce qui, encore aujourd'hui, semble ouvrir une nouvelle et décisive voie de progrès dans l'histoire de notre Humanité. Le premier séminaire sur l'intelligence artificielle (IA) qu'organise le mathématicien John McCarthy (1927-2011), l'inventeur du terme, réunit son confrère Marvin Minsky (1927-2016) et Claude E. Shannon (1916-2001), le père de la théorie de l'information, Herbert A. Simon (1916-2001), spécialiste des organisations, le mathématicien Alan Newell (1927-1992). Ces deux derniers vont surprendre leur auditoire en présentant "Logic Theorist", conçu pour imiter les capacités de résolution de problèmes d'un humain et financé par Research and Development (RAND) Corporation : le dit programme démontrera en l'occurrence trente-huit des cinquante-deux premiers théorèmes des Principia Mathematica, de Bertrand Russell et Alfred North Whitehead. Ce premier programme d'intelligence artificielle fonctionne comme une machine logique capable d'enchaîner et d'articuler entre elles des propositions à de quelques prémisses. Malheureusement, si tous les participants de ce séminaire historique s'alignèrent sur le sentiment que l'IA était réalisable, la conférence ne répondra pas, semble-t-il, aux attentes de McCarthy.

De 1957 à 1974, l'IA connaît une période riche de promesses, portée par les prouesses technologiques qui dessinent un Nouveau Monde, fortement médiatisé. Dans cette première étape, il s'agit donc de résoudre tout problème en le décomposant en une série de buts intermédiaires (définir les algorithmes applicables à un problème), dont on explore chacune des voies jusqu'à ce que la solution soit trouvée (la recherche des fameuses heuristiques ou stratégies de résolution de problèmes propres à chaque domaine), à charge une fois formalisés, de de les traduire en programmes informatiques, c'est-à-dire en une série d'instructions codées en langage symbolique compréhensible par l'ordinateur. Sur ce principe, H.A. Simon et A. Newell conçoivent, en 1957, General Problem Solver (GPS), un programme informatique dont la vocation est de résoudre toute une classe de problèmes de même type, promesse étant faite de pouvoir bientôt créer une machine à traduire les langues (un objectif affiché par les gouvernants), jouer aux échecs, prendre des décisions. De fait, les organismes gouvernementaux comme la Defense Advanced Research Projects Agency (DARPA) vont désormais financer la recherche sur l'IA dans plusieurs établissements. Marvin Minsky déclare à Life Magazine en 1970: "from three to eight years we will have a machine with the general intelligence of an average human being" (dans trois à huit années, nous aurons une machine avec l'intelligence générale d'un être humain moyen).

En 1958, J. McCarthy crée le Lisp (List Processing, traitement de ligne), qui deviendra dans les années 1970 et 80 le langage type pour la recherche en intelligence artificielle. À partir des années 1960, les premiers systèmes experts sont mis au point. En 1965, Edward Feigenbaum (1936) crée Dentral, écrit en Lisp, et Joshua Lederberg, pionnier de la biologie moléculaire, un système expert en charge d'étudier la formation et la découverte d'hypothèses dans le domaine scientifique : en l'occurrence il sera utilisé en chimie organique pour identifier des molécules organiques inconnues. En 1966 naît Eliza, un programme de dialogue homme-machine conçu par Joseph Weizenbaum (1923-2008), un programme qui vise à tromper les utilisateurs en leur faisant croire qu'ils ont une conversation avec un être humain réel, et conçu pour imiter un thérapeute qui poserait des questions ouvertes et répondrait ensuite. Il s'agit du premier "chatterbot" qui aura par suite nombre d'émules avec les progrès effectués dans les domaines du traitement du langage naturel. Dans cette lignée, en 1970, Terry Winograd (1946) crée Shrdlu, un programme qui comprend et "répond" à des instructions (déplacer des objets sur un support) données en langage humain. C'est durant ca même année que paraît le premier numéro de la revue Artificial Intelligence....

Mais les promesses de développement de l'Intelligence artificielle s'avèrent plus complexes à mettre en oeuvre que prévues, les hypothèses de départ quant à la formalisation possible de notre pensée rencontrant très rapidement des limites. Limites technologiques que rencontre de même l'ordinateur : "computers were still millions of times too weak to exhibit intelligence..." (Hans Moravec). Ainsi, si les premiers traducteurs automatiques apparaissent dès les années 1950 (Georgetown IBM experiment, 1954), au-delà du mot à mot ou de la phrase simple, la phrase plus complexe nécessite la connaissance du contexte dans lequel le mot prend tout son sens. Noam Chomsky (1928) en 1956-57 formule une nouvelle théorie linguistique, la grammaire générative (GG), qu'il expose dans "Syntactíc Structures" et qui semblait permettre d'interpréter et de recomposer l'ordre des mots dans les phrases les plus complexes. Tout être humain possède une capacité naturelle (une compétence) à produire du langage, à construire des phrases en associant des mots selon des règles de grammaire, des règles sous-jacentes de production universelle, communes à toutes les langues. Expliquant ainsi comment un sujet parlant peut, à partir du nombre fini des mots de la langue et d'un nombre limité de règles, produire un nombre infini de phrases inédites. Cette hypothèse de pouvoir parvenir à générer des productions mentales à partir de règles fondamentales rejoignait le projet de construction de l'IA. En 1965, Chomsky publie "Aspects of the Theory of Syntax", qui représente le cadre théorique général de toutes ces études et constituera une référence dans l’histoire de la grammaire générative. Mais en recherchant l'ensemble des éléments nécessaires à l’interprétation sémantique d’une phrase, la quête des structures profondes a conduit rechercher sans fin possible des composants sémantiques ultimes et indécomposables et à s'enfermer dans une abstraction d'une complexité croissante.

L'lA appliquée au domaine de la perception, perception visuelle (reconnaissance des formes) ou auditive (reconnaissance vocale), l'IA pour ses capacités d'apprentissage, sont les quelques univers proprement, "naturellement", humain sur lesquels butte encore notre science. Hubert Dreyfus (1929-2017), professeur de philosophie à Berkeley, a mené dans les années 1970 et 1980 une croisade contre les prétentions de l'lA , et ce au sein même du Laboratoire d’Intelligence Artificielle du Massachusetts Institute of Technology. "What computers still can't do ? A Critique of Artificial Reason" (1972) : l'intelligence et l'expertise humaines dépendent principalement de processus inconscients plutôt que de manipulations symboliques conscientes, et ces compétences inconscientes ne peuvent jamais être pleinement saisies dans des règles formelles. Sa critique était basée sur les idées de philosophes européens tels que Merleau-Ponty et Heidegger, et s'adressait à la première vague de recherche sur l'IA qui utilisait des symboles formels de haut niveau pour représenter la réalité et tentait de réduire l'intelligence à la manipulation de symboles. Le "connectionisme" des années 1980 semble avoir tenu compte de ces remarques fondamentales...

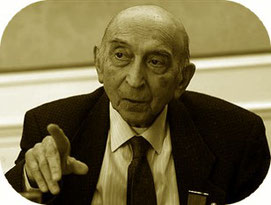

L'argument de la chambre chinoise, John Searle : l'ordinateur, la machine logique, ne peut pas "penser" pas car il n'accède pas au sens, au contenu, il ne fonctionne que sur des symboles abstraits, sans signification. - En 1980, le philosophe John Searle (1932) conteste une théorie de la conscience appelée fonctionnalisme (J.Fodor) qui explique l'esprit humain en termes informatiques lui déniant toute singularité : si un ordinateur peut réussir au test de Turing en convainquant un expert qu'il a un esprit, c'est qu'il en a vraiment un. Dans "Minds, Brains and Programs", Searle critique via l'argument de la "Chinese room", la possibilité d'intelligence artificielle. Imaginons qu'un homme, qui ne parle pas chinois, est enfermé dans une pièce aveugle avec un glossaire chinois contenant les réponses appropriées a certaines questions. On lui glisse sous la porte une feuille où une question est notée en chinois. ll cherche la réponse appropriée, l'écrit sur la feuille et la passe sous la porte. Comme il ne parle pas cette langue, il ne sait pas ce qu'il a lui-même écrit, il ne fait que suivre le schéma stimulus-réponse indiqué par le glossaire. Pour un observateur extérieur, il semble connaître le chinois même si les phrases qu'il lit et écrit n'ont aucun sens pour lui. De même, un ordinateur peut réussir au test de Turing mais il le fait en suivant aveuglément son programme. il, possède la syntaxe (structure logique), mais non pas la sémantique (compréhension du sens). Les ordinateurs peuvent simuler l'esprit humain, mais eux-mêmes n'en ont pas: "Le fonctionnement de l'esprit humain ne se résume pas à des processus formels ou syntaxiques. Par définition, nos états mentaux internes ont un contenu d`un certain type. Lorsque je pense à Kansas City, lorsque je me dis que j'aimerais bien une bière fraîche, lorsque je me demande si les taux d'intérêt vont baisser, mon état mental présente un contenu, et ce contenu s'ajoute à ses caractéristiques formelles, quelles qu'elles soient. (...) L'esprit est sémantique au sens où, en plus de sa structure formelle, il a un contenus.."

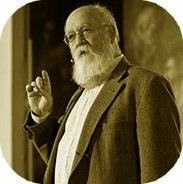

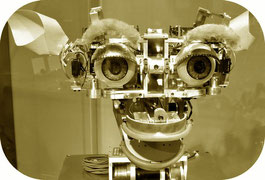

Daniel Clement Dennett (1942), philosophe (Content and Consciousness, 1969, Brainstorms, (1978) qui entend réintégrer l'étude de l'esprit dans le prolongement des sciences de la nature (le dualisme de Descartes, l'idée qu'un esprit immatériel interagit avec un corps matériel, n'est pour lui qu'un "cul-de-sac"), n'hésite pas quant à lui à contester toute distinction entre intelligence artificielle et conscience humaine : notre conscience est le produit d'interactions de milliards de neurones qui sont tous, comme il le dit, des "sortes de robots" (sorta robots). "J'argumente depuis des années que, oui, en principe, il est possible de réaliser la conscience humaine dans une machine. Après tout, c'est ce que nous sommes" ("We’re robots made of robots made of robots. We’re incredibly complex, trillions of moving parts. But they’re all non-miraculous robotic parts"). Dennett s'interrogent de plus sur ces humains qui s'acharnent à créer des mythes autour de mécanismes mentaux comme la conscience, à attribuer beaucoup plus de compréhension aux systèmes intelligents qu'ils n'en possèdent, à donner des noms aux assistants numériques, autant de pseudo "entités" qui n'ont rien de mystérieux mais font écran à toute compréhension (Caught in the Pulpit, 2013)..

Les spécialistes de l`lA doivent donc surmonter nombre d'obstacles, formaliser des modes de raisonnement plus souples, plus intuitifs, concevoir des architectures nouvelles adaptées à la reconnaissance des formes, la perception, l'apprentissage, modéliser des règles d'interprétation et de compréhension du sens des symboles et des concepts qu'il manipule. L'une des voies adoptées à partir des années 1970 sera de construire des programmes à "bases de connaissances". Une base de connaissances est un ensemble organisé de faits sur un domaine précis; un moteur d'inférence va interpréter et évaluer les faits dans cette base de connaissances afin de fournir une réponse (c'est la structure type d'un système expert). D'autres chercheurs vont se lancent alors dans la création et l'utilisation de "logiques floues" (fuzzy logic) : Lotfi A. Zadeh (1921-2017) de l'Université de Californie à Berkeley (Fuzzy Sets, 1965) avait observé que la logique informatique conventionnelle ne pouvait pas manipuler des données qui représentaient des idées subjectives ou vagues, d'où la conception d'une logique floue pour permettre aux ordinateurs de déterminer les distinctions entre les données avec des nuances de gris, semblable au processus du raisonnement humain (la Chine est en pointe sur ce créneau). La logique floue a depuis intégré avec succès nombre d'appareils dits "intelligents", mais l'action intelligente de haut niveau, telle qu'elle existe actuellement dans les ordinateurs, reste cependant épisodique, détachée, désintégrée....

Dans les années 1980, l'IA connaît un second souffle, la boîte à outils algorithmique s'étoffe et les fonds destinés à la recherche s'intensifient. Le gouvernement japonais va financé largement tant les systèmes experts que d'autres initiatives liées à l'IA dans le cadre de son "Fifth Generation Computer Project" (PGCF) de 1982 à 1990 (malheureusement, la plupart des objectifs ambitieux ne seront pas atteints). John Hopfield (un physicien connu pour son modèle de réseaux de neurones, 1982) et David Rumelhart (psychologue qui fournit aux informaticiens les premiers modèles testables de traitement neuronal, 1987) ont popularisé les techniques dite de "deep learning" qui permettaient aux ordinateurs d'apprendre par l'expérience, des techniques qui permettront de très rapides progrès dans les domaines de l'analyse du signal sonore ou visuel, notamment de la reconnaissance faciale, de la reconnaissance vocale, de la vision par ordinateur, du traitement automatisé du langage. Edward Feigenbaum poursuit ses recherches dans le domaine des systèmes experts qui imitent le processus décisionnel d'un expert humain (Knowledge Systems Laboratory, Stanford).

Durant ces fameuses 1980, pour permettre à l'ordinateur de se comporter plus "humainement" face à des situations données, et pour cela d'acquérir de la connaissance et de l'expérience sur le monde, les architectures classiques ont été abandonnées au profit de modèles connexionnistes ou à base de réseaux sémantiques. Au fond, on tente d'abandonner les approches symboliques, qui n’ont pas réalisé le type de résultats qui avait été prédit dans la mythologie de l’intelligence artificielle, au profit d'une modélisation proche des structures neuronales. Un réseau sémantique est un graphique composé d'étiquettes (ou nœuds), qui représentent des concepts, et de liens logiques (links) qui les relient. L'hypothèse est que la connaissance est organisée autour de concepts et de relations associées à ces concepts, la puissance du calculateur et l'étendue de la mémoire semblant assurer une évaluation sans limite de son environnement. La question de savoir si les réseaux neuronaux sont capables de mettre en œuvre un traitement de symboles de haut niveau tel que celui impliqué dans la génération et la compréhension du langage naturel a été vivement contestée. L'hypothèse se heurte encore et toujours à la notion de "sens", des relations associées à un concept peuvent dans la vie quotidienne aboutir à une véritable "explosion de sens" tant sont parfois particulièrement "subtiles" les simples échanges formulés au quotidien.

En 1961, Marvin Minsky, l'un des pères fondateurs de l'IA, écrivait : "Should we ask what intelligence “really is”? My own view is that this is more of an aesthetic question, or one of sense of dignity, than a technical matter! To me “intelligence” seems to denote little more than the complex of performances which we happen to respect, but do not understand. So it is, usually, with the question of “depth” in mathematics. Once the proof of a theorem is really understood, its content seems to become trivial" ( l'intelligence" ne me semble guère plus que l'ensemble des performances que nous respectons, mais que nous ne comprenons pas). En 1982, Marvin Minsky oppose le "bon sens" de l'humain à ces logiciels informatiques certes doués de capacités de mémoire exceptionnelles, de force de calcul vertigineuse, de logique irréprochable. Il présente ainsi comme un butoir sans doute infranchissable pour tous les programmes d'IA existant le fameux "défi du canard" (the duck test) : "tous les canards volent" et "Charly est un canard", le logiciel peut en déduire que "donc Charly vole", mais si on lui apprend que le pauvre Charly est mort, à quel moment le programme pourra-t-il répondre "Oh, excusez-moi, alors Charly ne vole pas... "? Les systèmes à bases de connaissances restent donc confinés dans des domaines de connaissances étroits et très spécialisés.

L'lA est l'objet de nombre de développements théoriques et semble progresser à travers ses multiples recherches, mais les réalisations opérationnelles restent assez limitées et spécialisées dans quelques domaines : les jeux logiques, les systèmes experts, la robotisation. "Je voudrais construire des agents mobiles complètement autonomes qui pourraient coexister dans le monde avec les êtres humains et qui seraient considérés par les humains comme des êtres intelligents de plein droit", écrit Rodney Brooks, fondateur de iRobot en 1990 qui a vendu plus de 8 millions de robots domestiques, et a déployé plus de 5 000 robots de défense et de sécurité, en 2012. "Nous construisons nos robots mobiles pour mener une enquête sur l’intelligence et donc pour apprendre ce dont nous avons besoin pour construire un système que nous considérerions comme intelligent..." Et Rodney Brooks ajoutera, "L’intelligence artificielle s’est effondrée sur la question de la représentation. Quand on aborde l’intelligence sous l’angle de son accroissement, en s’appuyant exclusivement sur la perception et l’action, on n’a plus besoin de se reposer sur la représentation" (Intelligence without Representation, 1987, MIT AI Lab).

"L’émergence d’une crise totale au sein du paradigme de l’intelligence artificielle tel qu’il s’est développé pendant trente ans", tel est le constat à la fin des années 1980, les ambitions initiales de l'IA semblent un lointain souvenir, alors que le monde de l'informatique continue son expansion, et la vitesse et les capacités de traitement de l'ordinateur ne cessent de progresser. Certains des initiateurs de l'IA comme T. Winograd se lancent même dans une sévère autocritique des prétentions de l'lA (une IA définie comme "théorie du calcul qui essaye de dupliquer les capacités cognitives de haut niveau d’une façon qui les fasse ressembler à celles des humains"), au nom de la radicale spécificité de la pensée humaine, qu'une machine physique sera toujours inapte à modéliser (Terry Winograd, Fernando Flores, L'intelligence artificielle en question, PUF).

Plus modestement, mais plus efficacement, l'intelligence artificielle et le cognitivisme portent désormais leurs efforts sur des réalisations plus spécialisées, plus opérationnelles, plus modestes. En parallèle, une part de l'effort cognitiviste privilégie l'analyse des utilisateurs et de leurs activités, décrites en termes de tâches, d’information et d’opérations mentales. "En laissant de côté la question de savoir comment des machines peuvent être rendues intelligentes, nous pouvons poser une autre question à propos de la technologie : qu’est-ce qui rend, pour les gens, les systèmes informatiques utilisables ? Dans les travaux concernant l’interaction homme-machine, le souci n’est pas de savoir si les machines sont comme les êtres humains dans leurs pensées et leurs actions, mais plutôt de savoir si elles constituent des outils qui peuvent être utilisés efficacement". C'est ainsi que Alan Kay (1940) qui travaillait à Xerox Parc sur le langage Smalltalk (1972), l'un des premiers langages de programmation à disposer d'un environnement de développement intégré complètement graphique, se tourne vers les interfaces graphiques qui vont devenir populaires grâce au Macintosh de Apple (1984), succédant à la fameuse "métaphore du bureau" apparue dans l'ordinateur Xerox Star, construit en 1981.

Un demi-siècle après sa création, nombre de spécialistes privilégient désormais une "IA faible", mais qui se veut opérationnelle rapidement, opposée à l' "IA forte" des origines (reconstruire la façon dont l'homme pense pour le surpasser). Paradoxalement, c'est alors qu'elle ne bénéficie plus de financement gouvernemental et du soutien médiatique, que l'IA va atteindre au cours des années 1990 et 2000, bon nombre de ses objectifs historiques. L'intelligence ne peut pas émerger de simples calculs. L'immense utilisation de l'heuristique, qui est nécessaire pour former des algorithmes intelligents, est une contradiction paradoxale à notre tentative de créer des connaissances....

L'lA se redéploie donc autour de domaines spécialisés, tels que les jeux stratégiques (jeu d'échecs, jeu de go, de dames), avec à la clé la fameuse "victoire" de la "force brute du calcul" de la machine (Deep Blue d'IBM) sur l'homme (le champion du monde d'échecs Garry Kasparov) en 1987. La même année, un logiciel de reconnaissance vocale, développé par Dragon Systems, a été implémenté sous Windows. Le traitement des langues se reconstruit autour de domaines de langue spécialisés. La reconnaissance visuelle progresse en dotant l'ordinateur de caméra sont capables d'analyser des objets sous différents angles ou en mouvement. La robotique est désormais entrée dans l'ère industrielle, se substituant à l'humain pour des tâches très spécialisées (l'une des principales raisons de l'augmentation du nombre de robots est qu'il est plus facile et moins coûteux de réaliser des robots que des applications).

A la fin des années 1990, Kismet, un robot développé par Cynthia Breazeal, au Massachusetts Institute of Technology, semble en capacité de reconnaître et d'afficher des émotions. Les systèmes experts abordent très opérationnellement des "micro-mondes" tels que l'aide à la décision financière, à la régulation de trafic, de transport, au diagnostic médical. Et surtout le concept d'apprentissage profond (deep learning) prend un nouvel élan décisif dans les années 2010, avec la convergence des réseaux de neurones artificiels, des algorithmes d'analyse discriminante et apprenants, de puissance des machines qui permettent de traiter des données massives, des bases de données gigantesques (nous sommes à l'ère des "big data") en capacité désormais d'entraîner des systèmes de grandes tailles, au fond les grandes bases de données et l'informatique massive permettent simplement à l'intelligence artificielle d'apprendre par la force brute : en attendant que la loi de Moore (1965) ne nous rattrape à nouveau: tous les 18 mois il y a doublement du nombre de transistors, rendant les ordinateurs rapidement obsolètes…

Artificial Intelligence is Everywhere? Dans un certain sens, oui. Mais plus encore, l'approche IA est désormais infléchie : il s'agit de simuler des comportements humains "intelligents" par des méthodes d'ïngénieurs, sans se soucier de savoir si l`homme procède de la même façon. Signe que les algorithmes marquent le pas, signe qu'un système de symboles n'est pas suffisant pour décrire le monde. On parle donc aujourd'hui de logiciel "d'aide" à la création ou à la décision plutôt que de machine qui remplacerait l'humain. Nous sommes loin des objectifs finaux du traitement du langage naturel, de la pensée abstraite et de la reconnaissance de soi…

"Living with AI" - En ce début du XXIe siècle, commence véritablement à se poser la grande question de l'impact de l'Intelligence artificielle sur nos existences, et plus encore sur nos libertés...

Si de nombreux dispositifs à base d'IA s'implantent progressivement dans des domaines très spécifiques et sans lien les uns avec autres (gestion,

transports, communication, par exemple), une technologie parmi toutes concentre toutes les interrogations sinon les inquiétudes, la technologie de la reconnaissance

faciale...

L'un des pères de la technologie de reconnaissance faciale, largement méconnu, fut Woody Bledsoe (1921-1995), fils d'un métayer de Maysville,

Oklahoma, qui travailla partir de 1966 au département de mathématiques et d'informatique de l'université du Texas à Austin, rejoignit très tôt l'Église de Jésus-Christ des Saints des Derniers

Jours, et travailla épisodiquement pour la CIA. A cette époque, un ordinateur ne pouvait alimenter sa matière algorithmique à partir de millions de photos...

La reconnaissance faciale (facial recognition) est devenue un élément de sécurité individuel jugé incontournable pour les téléphones, les ordinateurs

portables, les passeports et les applications de paiement, elle promet de révolutionner le secteur de la publicité ciblée, d'accélérer le diagnostic de certaines maladies, de marquer sur

Instagram ses relations, des jeux bien innocents pour le commun des mortels. De la justification individuelle, nous passons à la légitimité sociale globale, une étape supplémentaire est franchie

avec la mise en oeuvre de cette technologie par les services de l'immigration de tous les pays dits civilisés, dernière étape qui va nourrir inexorablement les enjeux de puissance de tous

ces hommes de pouvoir que nous laissons s'installer dans nos démocraties...

Toutes les structures gouvernementales de part le monde sont désormais tentées par la mise en oeuvre et le développement de ces technologies de la

reconnaissance faciale : alors que l'État chinois ordonne que tous les nouveaux utilisateurs de téléphones portables se soumettent à des systèmes d'authentification par reconnaissance faciale,

les géants technologiques américains n'hésitent plus à intégrer dans toutes leurs offres des dispositifs similaires et à stocker des millions de visages dans les bases de données qui ne demandent

qu'à être rapprochées.

Contrôler les finalités de cette technologie s'avère d'une rare complexité. Il s'agit en effet d'une technologie omniprésente mais quasi-invisible, en rapide évolution (on est passé de la reconnaissance faciale à celle des attitudes), capable d'auto-apprentissage (toujours grâce au stockage et marquage de millions d'images), qui, associée à d'autres techniques (comportementales, cognitives), systèmes de géolocalisation et bases de données sociales, permettent de contrôler et mémoriser les supposées déviances d'attitude de chacun d'entre nous. Une fois de plus dans notre histoire, si la volonté politique dépasse de loin la crédibilité de la technologie, elle seule est en capacité de susciter des investissements colossaux pour la développer en l'état, - au fond, sa maturité leur importe peu -, d'étendre et de justifier nombre d'expérimentations qui portent en elles une légitimité que personne n'ose plus contester : les défenseurs de la liberté et des droits de l'homme se mobilisent à peine....